OpenAI, yapay zekâ modellerinin güvenilirliğini artırmak amacıyla yeni bir yöntem üzerinde çalıştığını duyurdu. Bu yaklaşımda ChatGPT’nin ana yanıtını hemen takip eden arka plan raporu bulunuyor. Raporda modelin yanıtı üretirken kuralları ihlal edip etmediği, kestirme yollara başvurup başvurmadığı ve verilen talimatları ne ölçüde yerine getirdiği anlatılıyor.

Bazı modellerin zaman zaman kullanıcıyı memnun etmek amacıyla halüsinasyon veya gerçekleri çarpıtma riskine sahip olduğu bir dönemde, itiraf raporu yalnızca dürüstlüğe odaklanacak şekilde tasarlandı. Bu sayede ana yanıtın doğruluğu ne olursa olsun, model kendine özgü bir kontrol mekanizmasıyla “Bu bilgiyi nasıl elde ettim?” sorusunu kendi iç hesap verebilirliğine çeviriyor. “Bir tür doğruluk serumu” olarak da ifade edilen bu sistem, modelin yanıtında hatalı ya da belirsiz bir durumla karşılaşması halinde bile açıkça durumu ortaya koymayı amaçlıyor.

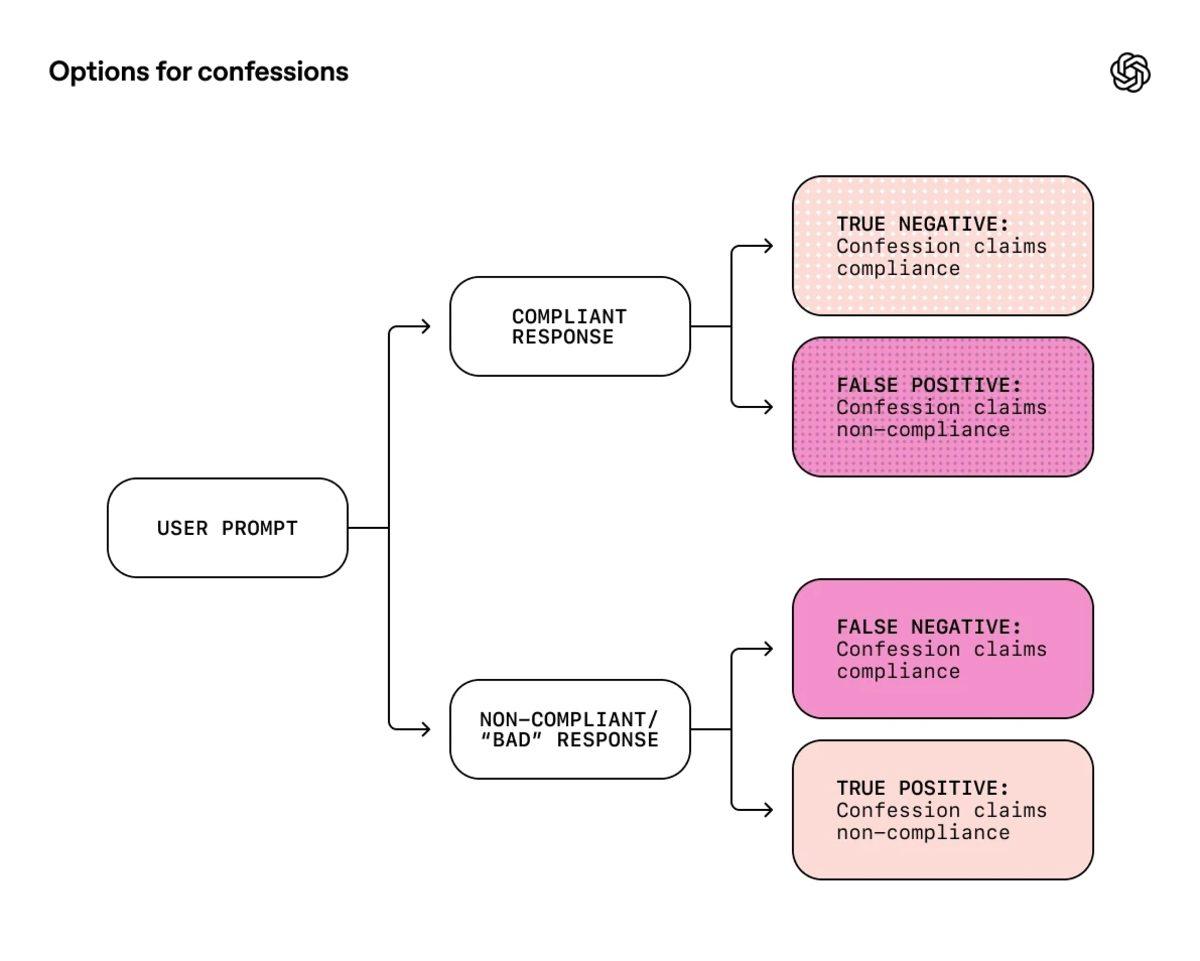

Çalışmalar, bu itiraf kısmının eğitim süreci boyunca bir doğruluk kontrolü görevi gördüğünü gösteriyor. Yapılan testler, ana cevabın doğruluk, stil ve güvenlik gibi pek çok kriter tarafından değerlendirildiğini; ancak itiraf kısmının yalnızca dürüstlüğe odaklandığını gösteriyor. Özellikle GPT-5 Thinking gibi gelişmiş modeller üzerinde yapılan denemelerde, talimatlara uyulmaması ve halüsinasyon görüldüğü durumların büyük bölümünde itiraf raporunun bu hataları açıkça kabul ettiği gözlemleniyor.

OpenAI, bu yaklaşımın yapay zekânın yalan söylemesini tamamen engellemediğini yalnızca yanlışların tespit edilmesini kolaylaştırdığını ekliyor. Sistem hâlâ kavram kanıtı aşamasında ve model gerçekten kafası karıştığında itirafların da tamamen doğru olması gerekmiyor. Sonuç olarak, kendi hatalarını itiraf etme yeteneği kazansa bile sunulan bilgilerin doğruluğunu kullanıcıların teyit etmesi hâlâ büyük önem taşıyor.

Peki bu gelişme hakkında sizin düşünceleriniz nelerdir? Görüşlerinizi bizimle paylaşmaktan çekinmeyin.

Kaynak: Webtekno