Geçtiğimiz günlerde OpenAI, yeni bir makale yayınladı. Bu makalede eski GPT-2 modelindeki nöronların davranışları için açıklamalar yazmak üzere GPT-4 dil modelini kullanan bir tekniğin ayrıntılarına yer veriliyor. Buradaki hedef ise hudut ağlarının ürettikleri çıktıları neden oluşturduklarını açıklamak.

Geçtiğimiz günlerde OpenAI, yeni bir makale yayınladı. Bu makalede eski GPT-2 modelindeki nöronların davranışları için açıklamalar yazmak üzere GPT-4 dil modelini kullanan bir tekniğin ayrıntılarına yer veriliyor. Buradaki hedef ise hudut ağlarının ürettikleri çıktıları neden oluşturduklarını açıklamak.

Büyük lisan modelleri (LLM) teknoloji dünyasını fethederken, yapay zeka (AI) araştırmacıları hala kaputun altındaki fonksiyonellikleri ve yetenekleri hakkında çok fazla şey bilmiyorlar. OpenAI, yayınlanan makalesinin birinci cümlesinde “Dil modelleri daha yetenekli hale geldi ve daha yaygın olarak kullanılmaya başlandı, ancak nasıl çalıştıklarını anlamıyoruz” diyerek bunu açıkça itiraf ediyor.

Neden çalıştıklarını bilmiyoruz

Çerçevenin dışından bakanlar için bu söz, sadece LLM’lerden elde edilen gelire bağlı olmakla kalmayıp tıpkı vakitte onları insan ötesi muhakeme yeteneği düzeylerine çıkarmayı uman bir şirketten gelen çarpıcı bir itiraf üzere görünebilir.

Çerçevenin dışından bakanlar için bu söz, sadece LLM’lerden elde edilen gelire bağlı olmakla kalmayıp tıpkı vakitte onları insan ötesi muhakeme yeteneği düzeylerine çıkarmayı uman bir şirketten gelen çarpıcı bir itiraf üzere görünebilir. Ancak bir hudut ağının ferdî nöronlarının çıktılarını üretmek için birlikte nasıl çalıştığını tam olarak “bilmeme” durumunun âlâ bilinen bir ismi bulunuyor: Kara kutu. Yani, mevcut durumda yapay zeka sistemlerinden bir şeyler istiyoruz ve onlar da bir bizlere bir karşılık veriyor, lakin bu iki süreç ortasındaki süreçte (kara kutu) ne olduğu bir gizem.

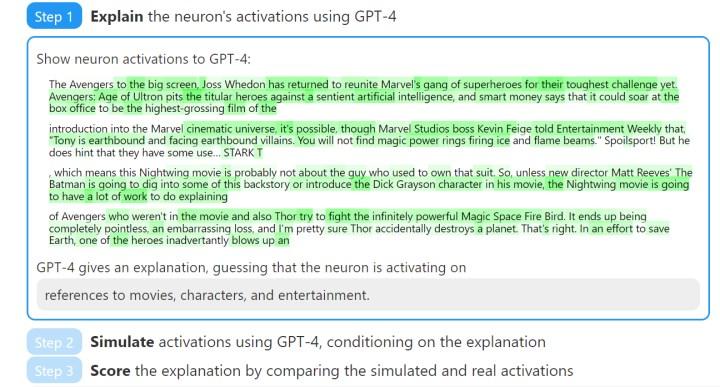

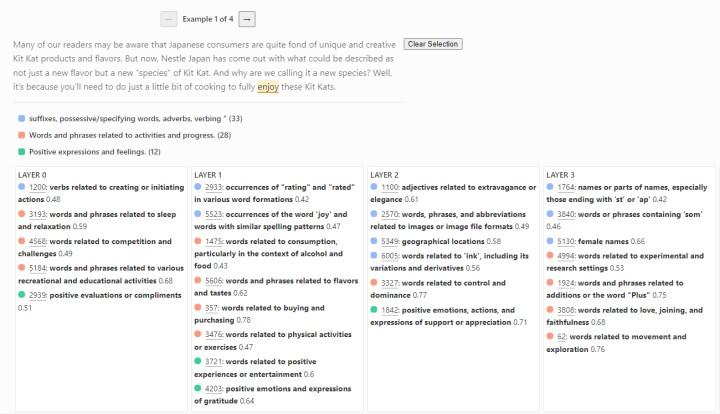

Kara kutunun içine bakmak maksadıyla OpenAI’daki araştırmacılar GPT-4 lisan modelini kullanarak GPT-2 üzere çok daha az karmaşık bir lisan modelindeki nöronların davranışları için doğal lisan açıklamaları oluşturdu ve kıymetlendirdi. Teoride, yorumlanabilir bir AI modeline sahip olmak, bu sistemlerin istendiği bir halde çalışmasına katkıda bulunabilir.

Çalışma halleri anlaşılabilirse eksiklikleri giderilebilir

Bilindiği üzere insan beyninde 100 milyar civarında nöron bulunuyor. Bir hudut ağında nöron, bilgiyi alan, işleyen ve bir çıktı üreten küçük bir karar verme ünitesi üzeredir, tıpkı aldığı sinyallere nazaran karar veren küçük bir beyin hücresi üzere. OpenAI’da bu yapay zeka nöronlarının çalışma halini anlamaya çalışıyor ancak görünüşe nazaran en azından şimdilik en gelişmiş yapay zeka modellerinden olan GPT-4 bile nöronları yorumlamakta zayıf kalıyor.

Bilindiği üzere insan beyninde 100 milyar civarında nöron bulunuyor. Bir hudut ağında nöron, bilgiyi alan, işleyen ve bir çıktı üreten küçük bir karar verme ünitesi üzeredir, tıpkı aldığı sinyallere nazaran karar veren küçük bir beyin hücresi üzere. OpenAI’da bu yapay zeka nöronlarının çalışma halini anlamaya çalışıyor ancak görünüşe nazaran en azından şimdilik en gelişmiş yapay zeka modellerinden olan GPT-4 bile nöronları yorumlamakta zayıf kalıyor. OpenAI araştırmacıları, yapay zeka modelleri daha gelişmiş hale geldikçe, üretilen açıklamaların kalitesinin artacağını ve bu karmaşık sistemlerin iç işleyişine dair daha âlâ bilgiler sunacağını umuyor. OpenAI, araştırma makalesini, her adımın örnek dökümlerini içeren, metnin vurgulanan kısımlarını ve bunların makul nöronlara nasıl karşılık geldiğini gösteren etkileşimli bir web sitesinde yayınladı. Firma çalışmalarına devam edeceğini belirtiyor.

Eğer “yorumlanabilirlik” alanında istenen muvaffakiyet sağlanırsa o vakit ChatGPT ve başkalarının neden bir şeyler uydurduğunu anlayabilir ve bu kritik sorun çözülebilir. Çünkü bu, tıpkı insanların hastalandıklarında tedavi edilmeleri üzere bir süreç. Bir meselemiz varsa hastaneye sarfiyat muayene olur ve teşhis konulur. Teşhis konulunca da buna nazaran ilaç verilir. Şimdilik yapay zeka modellerini kesin doğrulukla “muayene” edemiyoruz.