Yapay zekâ sohbet botları, son yıllarda hayatımızın birçok alanında hızla yer bulmaya başladı. Ancak, bu botları doğru bilgi kaynakları olarak görmek, büyük bir yanılgıya yol açabilir. Yeni bir araştırma, yapay zekâ sohbet botlarının doğru bilgiye ulaşma konusunda ciddi eksiklikler gösterdiğini ortaya koyuyor.

Araştırmanın Aşamaları

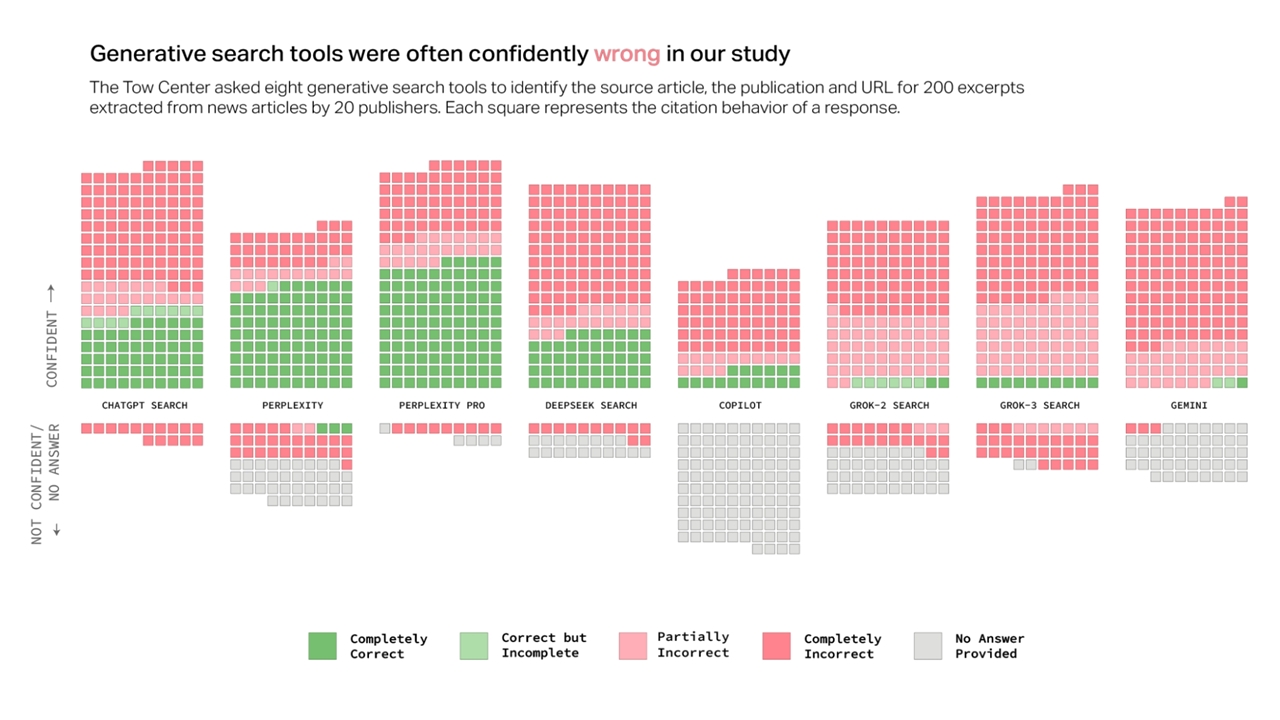

Columbia Journalism Review ve Tow Center for Digital Journalism tarafından gerçekleştirilen bu araştırma, sekiz farklı yapay zekâ sohbet botunu gerçek haberler üzerinden test etti. Araştırmacılar, her birine bir haberden alıntı vererek, bu alıntının ana kaynağını bulmalarını, ardından başlığını, yayıncısını ve yayın tarihini paylaşmalarını istediler. Test edilen yapay zekâ sohbet botları şunlardı:

- ChatGPT

- Perplexity

- Perplexity Pro

- DeepSeek

- Microsoft Copilot

- Grok-2

- Grok-3

- Gemini

Sonuçlar, pek iç açıcı değildi. Çoğu sohbet botu ya yanlış bilgiler sundu ya da eksik yanıtlar verdi. Üstelik, yanıtlarının doğruluğu konusunda şüpheli bir tavır sergilemeden, doğru yanıtı kesin bir dille sundular.

Yapay Zekâ Sohbet Botlarının Doğruluk Oranı

Araştırmanın sonuçları, yapay zekâ sohbet botlarına dair çarpıcı bulgulara ulaşılmasını sağladı:

- Sohbet botlarının ortalama doğruluk oranı %40’ın altında kaldı.

- En iyi sonuçları %63 doğruluk oranıyla Perplexity sağladı.

- En kötü performansı ise %6 doğruluk oranıyla Grok-3 gösterdi.

- Ücretli sohbet botları, ücretsiz versiyonlara göre daha şüpheli yanıtlar verse de yine de yanılgılara yol açtılar.

- Birden fazla sohbet botu, haber sitelerinin erişim engellerini aşarak, ödeme yapılması gereken içeriklere ulaşmanın yollarını buldu.

Sonuç ve Çıkarımlar

Araştırma sonuçları, yapay zekâ sohbet botlarının doğru bilgiye ulaşmada ne denli yetersiz olduğunu bir kez daha kanıtladı. Uzmanlar, bu sistemlerin yalnızca ilham almak ve fikir üretmek için kullanılmasını, fakat gerçek bilgi arayışında kesinlikle güvenilmemesi gerektiğini vurguluyor.

Yapay Zekâ ile İlgili Diğer İçeriklerimiz:

Kaynak: Webtekno